Agrandir / Une image générée par l’IA de robots regardant à l’intérieur d’un cerveau artificiel.

Diffusion stable

Mardi, OpenAI a publié un nouveau document de recherche détaillant une technique qui utilise son modèle de langage GPT-4 pour écrire des explications sur le comportement des neurones dans son ancien modèle GPT-2, bien qu’imparfaitement. C’est un pas en avant pour “l’interprétabilité”, qui est un domaine de l’IA qui cherche à expliquer pourquoi les réseaux de neurones créent les sorties qu’ils font.

Alors que les grands modèles de langage (LLM) conquièrent le monde de la technologie, les chercheurs en IA ne savent toujours pas grand-chose de leurs fonctionnalités et capacités sous le capot. Dans la première phrase de l’article d’OpenAI, les auteurs écrivent : “Les modèles de langage sont devenus plus performants et plus largement déployés, mais nous ne comprenons pas comment ils fonctionnent”.

Pour les étrangers, cela ressemble probablement à un aveu étonnant de la part d’une entreprise qui non seulement dépend des revenus des LLM, mais espère également les accélérer à des niveaux de capacité de raisonnement au-delà de l’humain.

Mais cette propriété de “ne pas savoir” exactement comment les neurones individuels d’un réseau de neurones travaillent ensemble pour produire ses sorties porte un nom bien connu : la boîte noire. Vous alimentez les entrées du réseau (comme une question) et vous obtenez des sorties (comme une réponse), mais tout ce qui se passe entre les deux (à l’intérieur de la “boîte noire”) est un mystère.

Pour tenter de jeter un coup d’œil à l’intérieur de la boîte noire, les chercheurs d’OpenAI ont utilisé son modèle de langage GPT-4 pour générer et évaluer des explications en langage naturel du comportement des neurones dans un modèle de langage beaucoup moins complexe, tel que GPT-2. Idéalement, disposer d’un modèle d’IA interprétable contribuerait à l’objectif plus large de ce que certains appellent “l’alignement de l’IA”, garantissant que les systèmes d’IA se comportent comme prévu et reflètent les valeurs humaines. Et en automatisant le processus d’interprétation, OpenAI cherche à surmonter les limites de l’inspection humaine manuelle traditionnelle, qui n’est pas évolutive pour les grands réseaux de neurones avec des milliards de paramètres.

Publicité

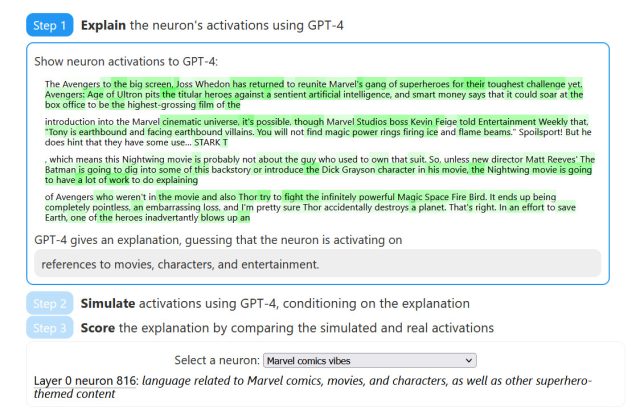

Agrandir / Le site Web du journal comprend des diagrammes qui montrent que GPT-4 devine quels éléments d’un texte ont été générés par un certain neurone dans un réseau de neurones.

Agrandir / Le site Web du journal comprend des diagrammes qui montrent que GPT-4 devine quels éléments d’un texte ont été générés par un certain neurone dans un réseau de neurones.

La technique d’OpenAI “cherche à expliquer quels modèles dans le texte provoquent l’activation d’un neurone”. Sa méthodologie comporte trois étapes :

- Expliquer les activations du neurone à l’aide de GPT-4

- Simuler le comportement d’activation des neurones à l’aide de GPT-4

- Comparez les activations simulées avec les activations réelles.

Pour comprendre le fonctionnement de la méthode OpenAI, vous devez connaître quelques termes : neurone, circuit et tête d’attention. Dans un réseau de neurones, un neurone est comme une minuscule unité de prise de décision qui recueille des informations, les traite et produit une sortie, tout comme une minuscule cellule cérébrale prenant une décision en fonction des signaux qu’elle reçoit. Un circuit dans un réseau neuronal est comme un réseau de neurones interconnectés qui travaillent ensemble, transmettant des informations et prenant des décisions collectivement, semblable à un groupe de personnes collaborant et communiquant pour résoudre un problème. Et une tête d’attention est comme un projecteur qui aide un modèle de langage à prêter plus d’attention à des mots spécifiques ou à des parties d’une phrase, lui permettant de mieux comprendre et de capturer des informations importantes lors du traitement du texte.

En identifiant des neurones et des têtes d’attention spécifiques au sein du modèle qui doivent être interprétés, GPT-4 crée des explications lisibles par l’homme pour la fonction ou le rôle de ces composants. Il génère également un score d’explication, qu’OpenAI appelle “une mesure de la capacité d’un modèle de langage à compresser et à reconstruire les activations neuronales à l’aide du langage naturel”. Les chercheurs espèrent que la nature quantifiable du système de notation permettra des progrès mesurables pour rendre les calculs des réseaux neuronaux compréhensibles pour les humains.

Publicité

Alors ça marche bien ? En ce moment, pas si génial. Au cours des tests, OpenAI a opposé sa technique à un entrepreneur humain qui effectuait manuellement des évaluations similaires, et ils ont constaté que GPT-4 et l’entrepreneur humain “obtenaient de mauvais résultats en termes absolus”, ce qui signifie que l’interprétation des neurones est difficile.

Une explication avancée par OpenAI pour cet échec est que les neurones peuvent être “polysémantiques”, ce qui signifie que le neurone typique dans le contexte de l’étude peut présenter plusieurs significations ou être associé à plusieurs concepts. Dans une section sur les limitations, les chercheurs d’OpenAI discutent à la fois des neurones polysémantiques et des “caractéristiques extraterrestres” comme limitations de leur méthode :

De plus, les modèles de langage peuvent représenter des concepts étrangers pour lesquels les humains n’ont pas de mots. Cela peut se produire parce que les modèles de langage se soucient de choses différentes, par exemple des constructions statistiques utiles pour les tâches de prédiction de jeton suivant, ou parce que le modèle a découvert des abstractions naturelles que les humains n’ont pas encore découvertes, par exemple une famille de concepts analogues dans des domaines disparates.

D’autres limitations incluent le fait d’être gourmand en calcul et de ne fournir que de courtes explications en langage naturel. Mais les chercheurs d’OpenAI sont toujours optimistes quant à la création d’un cadre pour l’interprétabilité méditée par la machine et les moyens quantifiables de mesurer les améliorations de l’interprétabilité à mesure qu’ils améliorent leurs techniques à l’avenir. À mesure que les modèles d’IA deviennent plus avancés, les chercheurs d’OpenAI espèrent que la qualité des explications générées s’améliorera, offrant de meilleures informations sur le fonctionnement interne de ces systèmes complexes.

OpenAI a publié son document de recherche sur un site Web interactif qui contient des exemples de décomposition de chaque étape, montrant des parties en surbrillance du texte et comment elles correspondent à certains neurones. De plus, OpenAI a fourni le code “d’interprétabilité automatisée” et ses neurones GPT-2 XL et ses ensembles de données d’explications sur GitHub.

S’ils découvrent exactement pourquoi ChatGPT invente les choses, tous les efforts en valent la peine.