Agrandir / Un chatbot généré par l’IA volant comme un super-héros.

Diffusion stable / OpenAI

Mardi, OpenAI a annoncé une mise à jour importante de ses grandes offres d’API de modèle de langage (y compris GPT-4 et gpt-3.5-turbo), y compris une nouvelle capacité d’appel de fonction, des réductions de coûts significatives et une option de fenêtre de contexte de 16 000 jetons pour le gpt- Modèle 3,5 turbo.

Dans les grands modèles de langage (LLM), la “fenêtre contextuelle” est comme une mémoire à court terme qui stocke le contenu de l’invite de saisie ou, dans le cas d’un chatbot, l’intégralité du contenu de la conversation en cours. Dans les modèles de langage, l’augmentation de la taille du contexte est devenue une course technologique, Anthropic ayant récemment annoncé une option de fenêtre de contexte de 75 000 jetons pour son modèle de langage Claude. De plus, OpenAI a développé une version de 32 000 jetons de GPT-4, mais elle n’est pas encore accessible au public.

Dans ce sens, OpenAI vient d’introduire une nouvelle version de gpt-3.5-turbo à 16 000 fenêtres contextuelles, appelée, sans surprise, “gpt-3.5-turbo-16k”, qui permet à une invite d’avoir jusqu’à 16 000 jetons de longueur. Avec quatre fois la longueur de contexte de la version standard de 4 000, gpt-3.5-turbo-16k peut traiter environ 20 pages de texte en une seule requête. Il s’agit d’un coup de pouce considérable pour les développeurs qui ont besoin que le modèle traite et génère des réponses pour de plus gros morceaux de texte.

Comme expliqué en détail dans le message d’annonce, OpenAI a répertorié au moins quatre autres changements majeurs apportés à ses API GPT :

- Introduction de la fonctionnalité d’appel de fonction dans l’API Chat Completions

- Versions améliorées et “plus orientables” de GPT-4 et gpt-3.5-turbo

- Une réduction de prix de 75 % sur le modèle d’intégration “ada”

- Une réduction de prix de 25% sur les jetons d’entrée pour gpt-3.5-turbo.

Avec l’appel de fonction, les développeurs peuvent désormais créer plus facilement des chatbots capables d’appeler des outils externes, de convertir le langage naturel en appels d’API externes ou d’effectuer des requêtes de base de données. Par exemple, il peut convertir des invites telles que « Envoyez un e-mail à Anya pour savoir si elle veut prendre un café vendredi prochain » en un appel de fonction tel que « send_email(to : string, body : string) ». En particulier, cette fonctionnalité permettra également une sortie cohérente au format JSON, que les utilisateurs d’API avaient auparavant des difficultés à générer.

Publicité

En ce qui concerne la “pilotabilité”, qui est un terme fantaisiste pour désigner le processus permettant au LLM de se comporter comme vous le souhaitez, OpenAI indique que son nouveau modèle “gpt-3.5-turbo-0613” inclura “une orientabilité plus fiable via le message système .” Le message système dans l’API est une invite de directive spéciale qui indique au modèle comment se comporter, par exemple “Vous êtes Grimace. Vous ne parlez que de milkshakes.”

En plus des améliorations fonctionnelles, OpenAI offre des réductions de coûts substantielles. Notamment, le prix des jetons d’entrée du populaire gpt-3.5-turbo a été réduit de 25 %. Cela signifie que les développeurs peuvent désormais utiliser ce modèle pour environ 0,0015 USD pour 1 000 jetons d’entrée et 0,002 USD pour 1 000 jetons de sortie, ce qui équivaut à environ 700 pages par dollar. Le modèle gpt-3.5-turbo-16k est au prix de 0,003 $ pour 1 000 jetons d’entrée et de 0,004 $ pour 1 000 jetons de sortie.

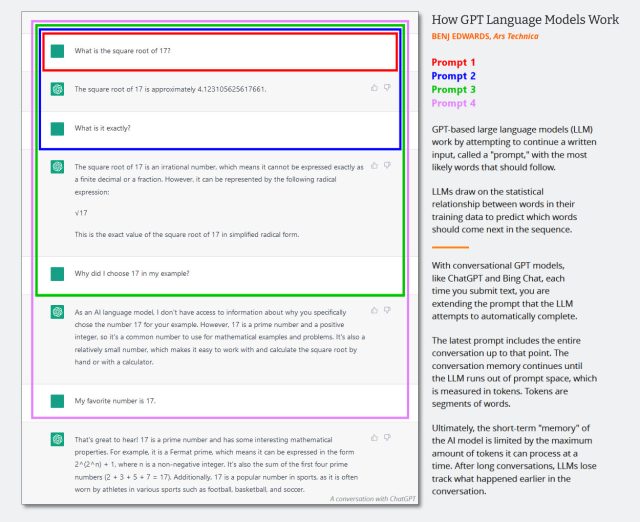

Agrandir / Schéma illustrant le fonctionnement de l’invite du modèle de langage conversationnel GPT.

Agrandir / Schéma illustrant le fonctionnement de l’invite du modèle de langage conversationnel GPT.

Benj Edwards / Ars Technica

En outre, OpenAI offre une réduction massive des coûts de 75 % pour son modèle d’intégration “text-embedding-ada-002”, qui est plus ésotérique à utiliser que ses frères conversationnels. Un modèle d’incorporation est comme un traducteur pour ordinateurs, transformant les mots et les concepts en un langage numérique que les machines peuvent comprendre, ce qui est important pour des tâches telles que la recherche de texte et la suggestion de contenu pertinent.

Comme OpenAI ne cesse de mettre à jour ses modèles, les anciens ne seront pas là pour toujours. Aujourd’hui, la société a également annoncé qu’elle entamait le processus de dépréciation de certaines versions antérieures de ces modèles, notamment gpt-3.5-turbo-0301 et gpt-4-0314. La société affirme que les développeurs peuvent continuer à utiliser ces modèles jusqu’au 13 septembre, après quoi les anciens modèles ne seront plus accessibles.

Il convient de noter que l’API GPT-4 d’OpenAI est toujours bloquée derrière une liste d’attente et pourtant largement disponible.