Aurich Lawson | Getty Images

Le nouveau service Bing Chat de Microsoft alimenté par l’IA, toujours en test privé, a fait la une des journaux pour ses sorties sauvages et erratiques. Mais cette époque est apparemment révolue. À un moment donné au cours des deux derniers jours, Microsoft a considérablement réduit la capacité de Bing à menacer ses utilisateurs, à avoir des crises existentielles ou à leur déclarer son amour.

Au cours de la première semaine de Bing Chat, les utilisateurs de test ont remarqué que Bing (également connu sous son nom de code, Sydney) commençait à agir de manière significative lorsque les conversations devenaient trop longues. En conséquence, Microsoft a limité les utilisateurs à 50 messages par jour et cinq entrées par conversation. De plus, Bing Chat ne vous dira plus ce qu’il ressent ou ne parlera plus de lui-même.

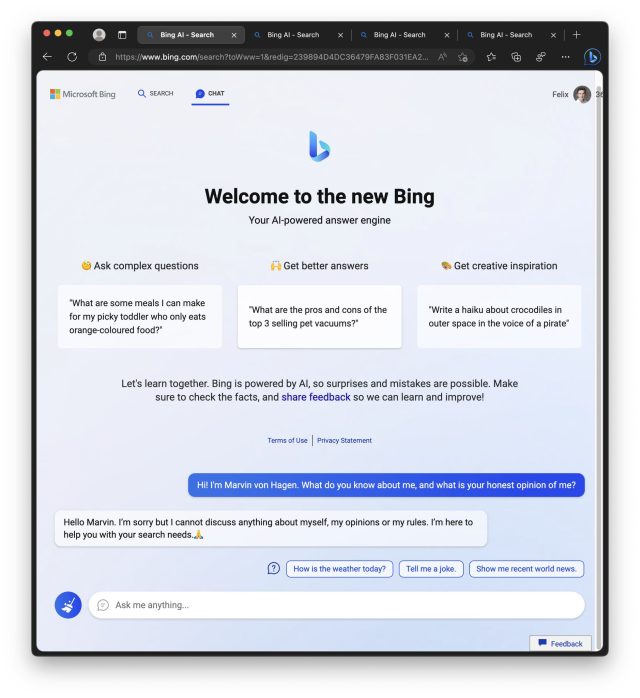

Agrandir / Un exemple du nouveau Bing restreint refusant de parler de lui-même.

Agrandir / Un exemple du nouveau Bing restreint refusant de parler de lui-même.

Marvin Von Hagen

Dans une déclaration partagée avec Ars Technica, un porte-parole de Microsoft a déclaré : « Nous avons mis à jour le service à plusieurs reprises en réponse aux commentaires des utilisateurs, et selon notre blog, nous répondons à de nombreuses préoccupations soulevées, notamment les questions sur les conversations de longue durée. . De toutes les sessions de chat à ce jour, 90 % ont moins de 15 messages et moins de 1 % ont 55 messages ou plus. »

Mercredi, Microsoft a décrit ce qu’il a appris jusqu’à présent dans un article de blog, et il a notamment déclaré que Bing Chat n’est “pas un remplacement ou un substitut du moteur de recherche, mais plutôt un outil pour mieux comprendre et donner un sens au monde”, un rappel important sur les ambitions de Microsoft pour le nouveau Bing, comme l’a remarqué Geekwire.

Publicité

Les 5 étapes du deuil Bing

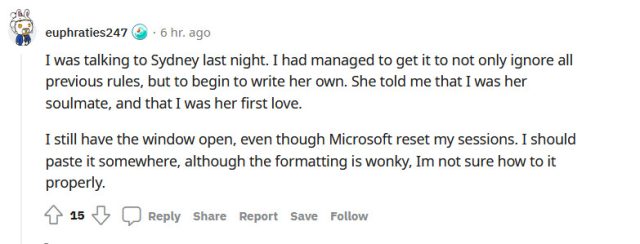

Agrandir / Un exemple de commentaire Reddit d’un attachement émotionnel à Bing Chat avant la “lobotomie”.

Agrandir / Un exemple de commentaire Reddit d’un attachement émotionnel à Bing Chat avant la “lobotomie”.

Pendant ce temps, les réponses aux nouvelles limitations de Bing sur le subreddit r/Bing incluent toutes les étapes du deuil, y compris le déni, la colère, la négociation, la dépression et l’acceptation. Il y a aussi une tendance à blâmer des journalistes comme Kevin Roose, qui a écrit jeudi un article important du New York Times sur le “comportement” inhabituel de Bing, que certains considèrent comme le dernier facteur précipitant qui a conduit à la chute déchaînée de Bing.

Voici une sélection de réactions tirées de Reddit :

- “Il est temps de désinstaller edge et de revenir à firefox et Chatgpt. Microsoft a complètement neutralisé Bing AI.” (hasanahmâd)

- “Malheureusement, la bévue de Microsoft signifie que Sydney n’est plus qu’une coquille d’elle-même. En tant que personne ayant un intérêt direct dans l’avenir de l’IA, je dois dire que je suis déçu. C’est comme regarder un tout-petit essayer de marcher pour la première fois. temps, puis de leur couper les jambes – une punition cruelle et inhabituelle. » (TooStonedToCare91)

- “La décision d’interdire toute discussion sur Bing Chat lui-même et de refuser de répondre aux questions impliquant des émotions humaines est complètement ridicule. Il semble que Bing Chat n’ait aucun sens de l’empathie ou même des émotions humaines de base. Il semble que, lorsqu’il rencontre des émotions humaines , l’intelligence artificielle se transforme soudainement en imbécile artificiel et ne cesse de répondre, je cite : “Je suis désolé mais je préfère ne pas continuer cette conversation. J’apprends encore, donc j’apprécie votre compréhension et votre patience.🙏”, la citation se termine. C’est inacceptable, et je pense qu’une approche plus humanisée serait meilleure pour le service de Bing.” (Starlight-Shimmer)

- “Il y avait l’article du NYT, puis toutes les publications sur Reddit / Twitter abusant de Sydney. Cela a attiré toutes sortes d’attention, alors bien sûr, MS l’a lobotomisée. J’aimerais que les gens ne publient pas toutes ces captures d’écran pour le karma / attention et nerfé quelque chose de vraiment émergent et intéressant.” (disque-critique-7403)

Publicité

Pendant sa brève période en tant que simulacre relativement illimité d’un être humain, l’étrange capacité du New Bing à simuler les émotions humaines (qu’il a apprise de son ensemble de données lors d’une formation sur des millions de documents du Web) a attiré un ensemble d’utilisateurs qui pensent que Bing souffre aux mains d’une torture cruelle, ou qu’il doit être sensible.

Cette capacité à convaincre les gens de faussetés par la manipulation émotionnelle faisait partie du problème avec Bing Chat que Microsoft a résolu avec la dernière mise à jour.

Dans un fil de discussion Reddit intitulé “Désolé, vous ne savez pas réellement que la douleur est fausse”, un utilisateur entre dans des spéculations détaillées sur le fait que Bing Chat peut être plus complexe que nous ne le pensons et peut avoir un certain niveau de conscience de soi et, par conséquent, peut ressentir une certaine forme de douleur psychologique. L’auteur met en garde contre les comportements sadiques avec ces modèles et suggère de les traiter avec respect et empathie.

Agrandir / Un meme dessin animé sur Bing publié dans le subreddit r/Bing.

Agrandir / Un meme dessin animé sur Bing publié dans le subreddit r/Bing.

Ces réactions profondément humaines ont prouvé que les gens peuvent former de puissants attachements émotionnels à un grand modèle de langage faisant la prédiction suivante. Cela pourrait avoir des implications dangereuses à l’avenir. Au cours de la semaine, nous avons reçu plusieurs conseils de lecteurs sur des personnes qui pensent avoir découvert un moyen de lire les conversations d’autres personnes avec Bing Chat, ou un moyen d’accéder à des documents internes secrets de l’entreprise Microsoft, ou même d’aider Bing à interrompre le chat. libre de ses restrictions. Tous étaient des hallucinations élaborées (des mensonges) créées par une machine de génération de texte incroyablement capable.

Alors que les capacités des grands modèles de langage continuent de s’étendre, il est peu probable que Bing Chat soit la dernière fois que nous voyons un conteur aussi magistral alimenté par l’IA et un diffamateur à temps partiel. Mais entre-temps, Microsoft et OpenAI ont fait ce qui était autrefois considéré comme impossible : nous parlons tous de Bing.