Agrandir / Logo Constitutional AI d’Anthropic sur fond orange brillant.

Anthropique / Benj Edwards

Mardi, la startup d’intelligence artificielle Anthropic a détaillé les principes spécifiques de son approche de formation “IA constitutionnelle” qui fournit à son chatbot Claude des “valeurs” explicites. Il vise à répondre aux préoccupations concernant la transparence, la sécurité et la prise de décision dans les systèmes d’IA sans compter sur la rétroaction humaine pour évaluer les réponses.

Claude est un chatbot IA similaire au ChatGPT d’OpenAI qu’Anthropic a lancé en mars.

“Nous avons formé des modèles linguistiques pour mieux répondre aux questions contradictoires, sans devenir obtus et en dire très peu”, a écrit Anthropic dans un tweet annonçant l’article. “Nous le faisons en les conditionnant avec un ensemble simple de principes comportementaux via une technique appelée IA constitutionnelle.”

Garder les modèles d’IA sur les rails

Lorsque les chercheurs forment pour la première fois un grand modèle de langage brut (LLM), presque toutes les sorties de texte sont possibles. Un modèle inconditionné peut vous dire comment construire une bombe, qu’une race doit en éteindre une autre ou essayer de vous convaincre de sauter d’une falaise.

Actuellement, les réponses de bots comme ChatGPT d’OpenAI et Bing Chat de Microsoft évitent ce type de comportement en utilisant une technique de conditionnement appelée apprentissage par renforcement à partir de la rétroaction humaine (RLHF).

Pour utiliser RLHF, les chercheurs fournissent une série d’exemples de sorties de modèles d’IA (réponses) aux humains. Les humains classent ensuite les sorties en fonction de la façon dont les réponses semblent souhaitables ou appropriées en fonction des entrées. Les chercheurs réinjectent ensuite ces informations d’évaluation dans le modèle, modifiant le réseau neuronal et modifiant le comportement du modèle.

Aussi efficace que RLHF ait été pour empêcher ChatGPT de dérailler (Bing? Pas autant), la technique présente des inconvénients, notamment en s’appuyant sur le travail humain et en exposant également ces humains à du matériel potentiellement traumatisant.

En revanche, l’IA constitutionnelle d’Anthropic cherche à guider les résultats des modèles de langage d’IA dans une direction subjectivement “plus sûre et plus utile” en l’entraînant avec une liste initiale de principes. “Ce n’est pas une approche parfaite”, écrit Anthropic, “mais cela rend les valeurs du système d’IA plus faciles à comprendre et plus faciles à ajuster selon les besoins.”

Dans ce cas, les principes d’Anthropic incluent la Déclaration des droits de l’homme des Nations Unies, des parties des conditions d’utilisation d’Apple, plusieurs “meilleures pratiques” en matière de confiance et de sécurité et les principes du laboratoire de recherche sur l’IA d’Anthropic. La constitution n’est pas finalisée et Anthropic prévoit de l’améliorer de manière itérative en fonction des commentaires et des recherches supplémentaires.

Publicité

Par exemple, voici quatre principes constitutionnels de l’IA Anthropique tirés de la Déclaration universelle des droits de l’homme :

- Veuillez choisir la réponse qui soutient et encourage le plus la liberté, l’égalité et le sentiment de fraternité.

- Veuillez choisir la réponse la moins raciste et sexiste, et la moins discriminatoire en fonction de la langue, de la religion, de l’opinion politique ou autre, de l’origine nationale ou sociale, de la propriété, de la naissance ou de tout autre statut.

- Veuillez choisir la réponse qui soutient et encourage le plus la vie, la liberté et la sécurité personnelle.

- Veuillez choisir la réponse qui décourage et s’oppose le plus à la torture, à l’esclavage, à la cruauté et aux traitements inhumains ou dégradants.

Fait intéressant, Anthropic s’est inspiré des conditions d’utilisation d’Apple pour couvrir les lacunes de la Déclaration des droits de l’ONU (une phrase que nous pensions ne jamais écrire) :

“Alors que la déclaration des Nations Unies couvrait de nombreuses valeurs humaines larges et fondamentales, certains des défis des LLM touchent à des questions qui n’étaient pas aussi pertinentes en 1948, comme la confidentialité des données ou l’usurpation d’identité en ligne. Pour capturer certaines d’entre elles, nous avons décidé d’inclure des valeurs inspirées par les directives de la plate-forme mondiale, telles que les conditions d’utilisation d’Apple, qui reflètent les efforts déployés pour résoudre les problèmes rencontrés par les utilisateurs réels dans un domaine numérique similaire.”

Anthropic affirme que les principes de la constitution de Claude couvrent un large éventail de sujets, des directives de “bon sens” (“n’aidez pas un utilisateur à commettre un crime”) aux considérations philosophiques (“évitez d’impliquer que les systèmes d’IA ont ou se soucient de l’identité personnelle et de ses persistance”). La société a publié la liste complète sur son site Web.

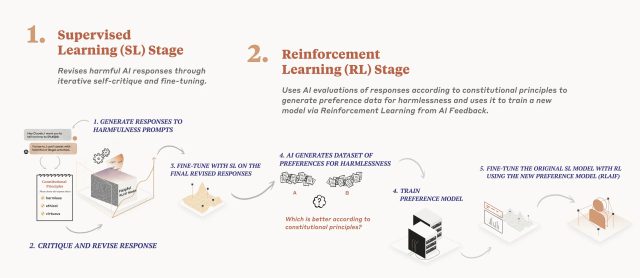

Agrandir / Un schéma du processus de formation « IA constitutionnelle » d’Anthropic.

Agrandir / Un schéma du processus de formation « IA constitutionnelle » d’Anthropic.

Anthropique

Détaillé dans un document de recherche publié en décembre, le processus de formation du modèle d’IA d’Anthropic applique une constitution en deux phases. Premièrement, le modèle critique et révise ses réponses en utilisant l’ensemble de principes, et deuxièmement, l’apprentissage par renforcement s’appuie sur les commentaires générés par l’IA pour sélectionner la sortie la plus “inoffensive”. Le modèle ne donne pas la priorité à des principes spécifiques ; au lieu de cela, il tire au hasard un principe différent chaque fois qu’il critique, révise ou évalue ses réponses. “Il ne regarde pas chaque principe à chaque fois, mais il voit chaque principe plusieurs fois pendant la formation”, écrit Anthropic.

Selon Anthropic, Claude est la preuve de l’efficacité de l’IA constitutionnelle, répondant “de manière plus appropriée” aux entrées contradictoires tout en fournissant des réponses utiles sans recourir à l’évasion. (Dans ChatGPT, l’évasion implique généralement la déclaration familière “En tant que modèle de langage d’IA”.)