Aujourd’hui, IBM a annoncé la dernière génération de sa famille de processeurs quantiques sur le thème des oiseaux, l’Osprey. Avec plus de trois fois le nombre de qubits de son processeur Eagle de la génération précédente, Osprey est le premier à proposer plus de 400 qubits, ce qui indique que la société reste sur la bonne voie pour lancer le premier processeur de 1 000 qubits l’année prochaine.

Malgré le nombre élevé de qubits, il n’est pas nécessaire de se précipiter et de chiffrer à nouveau toutes vos données sensibles pour l’instant. Alors que les taux d’erreur des qubits d’IBM se sont régulièrement améliorés, ils n’ont toujours pas atteint le point où les 433 qubits d’Osprey peuvent être utilisés dans un seul algorithme sans une très forte probabilité d’erreur. Pour l’instant, IBM souligne qu’Osprey est une indication que l’entreprise peut s’en tenir à sa feuille de route agressive pour l’informatique quantique et que le travail nécessaire pour le rendre utile est en cours.

Sur la route

Pour comprendre l’annonce d’IBM, il est utile de comprendre le marché de l’informatique quantique dans son ensemble. Il y a maintenant beaucoup d’entreprises sur le marché de l’informatique quantique, des startups aux grandes entreprises établies comme IBM, Google et Intel. Ils ont misé sur une variété de technologies, des atomes piégés aux électrons de réserve en passant par les boucles supraconductrices. Presque tous conviennent que pour atteindre le plein potentiel de l’informatique quantique, nous devons arriver là où le nombre de qubits se situe dans les dizaines de milliers et les taux d’erreur sur chaque qubit individuel suffisamment bas pour qu’ils puissent être liés ensemble en un plus petit nombre d’erreurs. corriger les qubits.

Il existe également un consensus général sur le fait que l’informatique quantique peut être utile pour certains problèmes spécifiques beaucoup plus tôt. Si le nombre de qubits est suffisamment élevé et que les taux d’erreur sont suffisamment faibles, il est possible que la réexécution de calculs spécifiques suffisamment de fois pour éviter une erreur obtienne toujours des réponses à des problèmes difficiles ou impossibles à résoudre sur des ordinateurs classiques.

La question est de savoir quoi faire pendant que nous nous efforçons de réduire le taux d’erreur. Étant donné que la probabilité d’erreurs varie en grande partie avec le nombre de qubits, l’ajout de plus de qubits à un calcul augmente la probabilité que les calculs échouent. J’ai eu un dirigeant d’une entreprise de qubits à ions piégés qui m’a dit qu’il serait trivial pour eux de piéger plus d’ions et d’avoir un nombre de qubits plus élevé, mais ils n’en voient pas l’intérêt – l’augmentation des erreurs rendrait cela difficile pour compléter tous les calculs. Ou, pour le dire différemment, pour avoir une bonne probabilité d’obtenir un résultat à partir d’un calcul, il faudrait utiliser moins de qubits que ce qui est disponible.

Publicité

Osprey ne change rien à tout cela. Bien que la personne d’IBM ne l’ait pas directement reconnu (et nous l’avons demandé deux fois), il est peu probable qu’un seul calcul puisse utiliser les 433 qubits sans rencontrer d’erreur. Mais, comme l’a expliqué Jerry Chow, directeur de l’infrastructure du groupe quantique d’IBM, l’augmentation du nombre de qubits n’est qu’une branche du processus de développement de l’entreprise. La publication des résultats de ce processus dans le cadre d’une feuille de route à long terme est importante en raison des signaux qu’elle envoie aux développeurs et aux utilisateurs finaux potentiels de l’informatique quantique.

Sur la carte

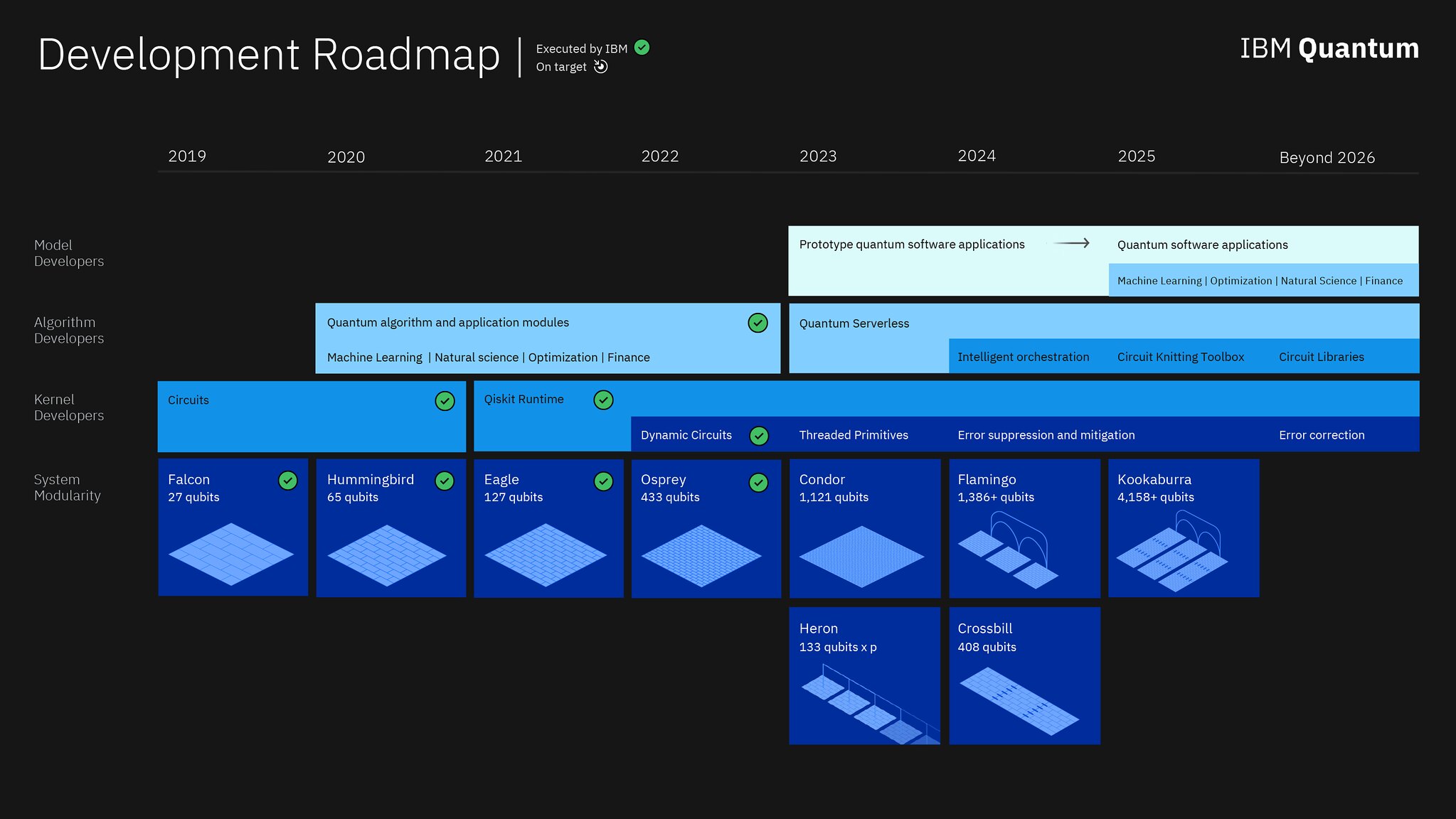

IBM a publié sa feuille de route en 2020, et il a appelé le processeur Eagle de l’année dernière à être le premier avec plus de 100 qubits, a obtenu le bon nombre de qubits d’Osprey et a indiqué que la société serait la première à effacer 1 000 qubits avec le Condor de l’année prochaine. L’itération de cette année sur la feuille de route prolonge la chronologie et fournit de nombreux détails supplémentaires sur ce que fait l’entreprise au-delà de l’augmentation du nombre de qubits.

La feuille de route quantique actuelle d’IBM est plus élaborée que son offre initiale.

L’ajout le plus notable est que Condor ne sera pas le seul matériel sorti l’année prochaine ; un processeur supplémentaire appelé Heron est sur la carte qui a un nombre de qubits inférieur mais a le potentiel d’être lié à d’autres processeurs pour former un package multi-puces (une étape qu’un concurrent dans l’espace a déjà franchie). Lorsqu’on lui a demandé quel était le plus grand obstacle à la mise à l’échelle du nombre de qubits, Chow a répondu que “c’est la taille de la puce réelle. Les qubits supraconducteurs ne sont pas les plus petites structures – ils sont en fait assez visibles à vos yeux.” L’installation d’un plus grand nombre d’entre eux sur une seule puce crée des défis pour la structure matérielle de la puce, ainsi que pour les connexions de contrôle et de lecture qui doivent être acheminées à l’intérieur de celle-ci.

“Nous pensons que nous allons tourner cette manivelle une fois de plus, en utilisant ce type de technologie de base à puce unique avec Condor”, a déclaré Chow à Ars. “Mais honnêtement, ce n’est pas pratique si vous commencez à fabriquer des puces uniques qui représentent probablement une grande proportion de la taille d’une tranche.” Ainsi, alors que Heron commencera comme une branche secondaire du processus de développement, toutes les puces au-delà de Condor auront la capacité de former des liens avec des processeurs supplémentaires.