Agrandir / Quelqu’un scanne son visage à l’aide des “techniques d’apprentissage automatique les plus avancées” d’Apple avec Apple Vision Pro lors d’une démo de la WWDC 2023.

Pomme

Au milieu de nouveaux produits impressionnants comme l’Apple Silicon Mac Pro et l’Apple Vision Pro révélés lors de l’événement d’ouverture de la WWDC 2023 de lundi, les présentateurs d’Apple n’ont jamais mentionné le terme “IA”, une omission notable étant donné que ses concurrents comme Microsoft et Google se sont fortement concentrés sur IA générative pour le moment. Pourtant, l’IA faisait partie de la présentation d’Apple, juste sous d’autres noms.

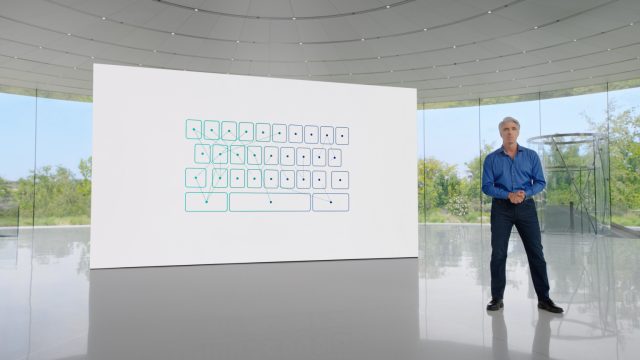

Alors que “IA” est un terme très ambigu de nos jours, entouré à la fois d’avancées étonnantes et d’un battage médiatique extrême, Apple a choisi d’éviter cette association et s’est plutôt concentré sur des termes tels que “apprentissage automatique” et “ML”. Par exemple, lors de la démo iOS 17, SVP of Software Engineering Craig Federighi parlé des améliorations apportées à la correction automatique et à la dictée :

La correction automatique est alimentée par l’apprentissage automatique sur l’appareil et, au fil des ans, nous avons continué à faire progresser ces modèles. Le clavier exploite désormais un modèle de langage de transformateur, qui est à la pointe de la technologie pour la prédiction de mots, ce qui rend la correction automatique plus précise que jamais. Et grâce à la puissance d’Apple Silicon, l’iPhone peut exécuter ce modèle chaque fois que vous appuyez sur une touche.

Notamment, Apple a mentionné le terme IA “transformateur” dans un discours d’ouverture d’Apple. La société a spécifiquement parlé d’un “modèle de langage de transformateur”, ce qui signifie que son modèle d’IA utilise l’architecture de transformateur qui a alimenté de nombreuses innovations récentes en matière d’IA générative, telles que le générateur d’images DALL-E et le chatbot ChatGPT.

Un modèle de transformateur (un concept introduit pour la première fois en 2017) est un type d’architecture de réseau neuronal utilisé dans le traitement du langage naturel (TAL) qui utilise un mécanisme d’auto-attention, lui permettant de hiérarchiser différents mots ou éléments dans une séquence. Sa capacité à traiter les entrées en parallèle a conduit à des améliorations significatives de l’efficacité et à des percées dans les tâches NLP telles que la traduction, la synthèse et la réponse aux questions.

Apparemment, le nouveau modèle de transformateur d’Apple dans iOS 17 permet des corrections automatiques au niveau de la phrase qui peuvent terminer un mot ou une phrase entière lorsque vous appuyez sur la barre d’espace. Il apprend également de votre style d’écriture, qui guide ses suggestions.

Publicité

Tout ce traitement de l’IA sur l’appareil est assez facile pour Apple en raison d’une partie spéciale des puces Apple Silicon (et des puces Apple antérieures, à commencer par l’A11 en 2017) appelée Neural Engine, qui est conçue pour accélérer les applications d’apprentissage automatique. Apple a également déclaré que la dictée “obtient un nouveau modèle de reconnaissance vocale basé sur un transformateur qui exploite le moteur neuronal pour rendre la dictée encore plus précise”.

Agrandir / Une capture d’écran de Craig Federighi parlant de la correction automatique dans iOS 17, qui utilise désormais un “modèle de langage de transformateur”.

Agrandir / Une capture d’écran de Craig Federighi parlant de la correction automatique dans iOS 17, qui utilise désormais un “modèle de langage de transformateur”.

Pomme

Au cours de la keynote, Apple a également mentionné “l’apprentissage automatique” à plusieurs autres reprises : lors de la description d’une nouvelle fonctionnalité d’écran de verrouillage de l’iPad (“Lorsque vous sélectionnez une photo en direct, nous utilisons un modèle d’apprentissage automatique avancé pour synthétiser des images supplémentaires”); Fonctionnalités PDF d’iPadOS (“Grâce aux nouveaux modèles d’apprentissage automatique, iPadOS peut identifier les champs d’un PDF afin que vous puissiez utiliser la saisie automatique pour les remplir rapidement avec des informations telles que les noms, les adresses et les e-mails de vos contacts.”); une fonction AirPods Adaptive Audio (“Avec le volume personnalisé, nous utilisons l’apprentissage automatique pour comprendre vos préférences d’écoute au fil du temps”); et une fonctionnalité de widget Apple Watch appelée Smart Stack (“Smart Stack utilise l’apprentissage automatique pour vous montrer des informations pertinentes au moment où vous en avez besoin”).

Apple a également lancé une nouvelle application appelée Journal qui permet la journalisation personnelle de textes et d’images (un peu comme un journal interactif), verrouillée et cryptée sur votre iPhone. Apple a déclaré que l’IA jouait un rôle, mais n’a pas utilisé le terme “IA”.

“Grâce à l’apprentissage automatique sur l’appareil, votre iPhone peut créer des suggestions personnalisées de moments pour inspirer votre écriture”, a déclaré Apple. “Les suggestions seront intelligemment organisées à partir d’informations sur votre iPhone, telles que vos photos, votre emplacement, votre musique, vos séances d’entraînement, etc. Et vous contrôlez ce qu’il faut inclure lorsque vous activez les suggestions et celles à enregistrer dans votre journal.”

Enfin, lors de la démo de la nouvelle Apple Vision Pro, la société a révélé que l’image en mouvement des yeux d’un utilisateur sur le devant des lunettes provient d’un avatar 3D spécial créé en scannant votre visage – et vous l’avez deviné, l’apprentissage automatique.