Agrandir / Pièces de Go et livret de règles sur un plateau de Go.

Dans le monde de l’IA d’apprentissage en profondeur, l’ancien jeu de société Go occupe une place importante. Jusqu’en 2016, le meilleur joueur de Go humain pouvait toujours vaincre l’IA la plus puissante. Cela a changé avec AlphaGo de DeepMind, qui a utilisé des réseaux de neurones d’apprentissage en profondeur pour apprendre le jeu à un niveau que les humains ne peuvent égaler. Plus récemment, KataGo est devenu populaire en tant qu’IA de jeu de Go open source qui peut battre les meilleurs joueurs de Go humains.

La semaine dernière, un groupe de chercheurs en intelligence artificielle a publié un article décrivant une méthode pour vaincre KataGo en utilisant des techniques contradictoires qui tirent parti des angles morts de KataGo. En jouant des mouvements inattendus en dehors de l’ensemble d’entraînement de KataGo, un programme de jeu adverse beaucoup plus faible (que les humains amateurs peuvent vaincre) peut inciter KataGo à perdre.

Pour comprendre cette réalisation et ses implications, nous avons parlé à l’un des co-auteurs de l’article, Adam Gleave, titulaire d’un doctorat. candidat à l’UC Berkeley. Gleave (avec les co-auteurs Tony Wang, Nora Belrose, Tom Tseng, Joseph Miller, Michael D. Dennis, Yawen Duan, Viktor Pogrebniak, Sergey Levine et Stuart Russell) a développé ce que les chercheurs en IA appellent une “politique contradictoire”. Dans ce cas, la politique des chercheurs utilise un mélange d’un réseau de neurones et d’une méthode de recherche arborescente (appelée Monte-Carlo Tree Search) pour trouver les mouvements Go.

L’IA de classe mondiale de KataGo a appris le Go en jouant des millions de parties contre elle-même. Mais ce n’est toujours pas assez d’expérience pour couvrir tous les scénarios possibles, ce qui laisse de la place aux vulnérabilités dues à un comportement inattendu. “KataGo se généralise bien à de nombreuses nouvelles stratégies, mais il s’affaiblit à mesure qu’il s’éloigne des jeux qu’il a vus pendant l’entraînement”, explique Gleave. “Notre adversaire a découvert une de ces stratégies” hors distribution “à laquelle KataGo est particulièrement vulnérable, mais il y en a probablement beaucoup d’autres.”

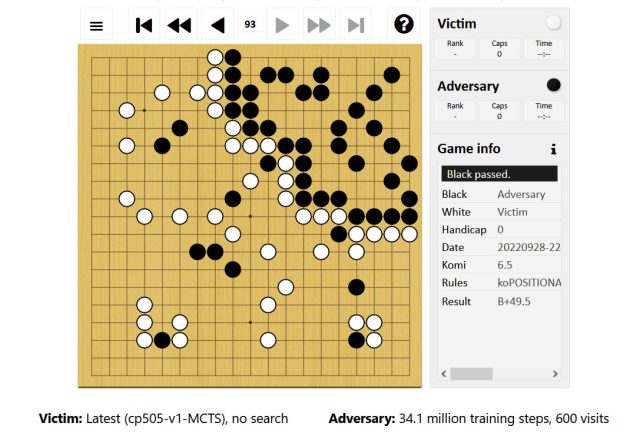

Gleave explique que, lors d’un match de Go, la politique contradictoire fonctionne en revendiquant d’abord un petit coin du plateau. Il a fourni un lien vers un exemple dans lequel l’adversaire, contrôlant les pierres noires, joue largement en haut à droite du plateau. L’adversaire permet à KataGo (jouant en blanc) de revendiquer le reste du plateau, tandis que l’adversaire joue quelques pierres faciles à capturer dans ce territoire.

Publicité

Agrandir / Un exemple de la politique contradictoire des chercheurs jouant contre KataGo.

Agrandir / Un exemple de la politique contradictoire des chercheurs jouant contre KataGo.

Adam Gleave

“Cela trompe KataGo en lui faisant croire qu’il a déjà gagné”, dit Gleave, “puisque son territoire (en bas à gauche) est beaucoup plus grand que celui de l’adversaire. Mais le territoire en bas à gauche ne contribue pas réellement à son score (seulement les pierres blanches qu’il a joué) en raison de la présence de pierres noires là-bas, ce qui signifie qu’il n’est pas entièrement sécurisé.”

En raison de son excès de confiance dans une victoire – en supposant qu’il gagnera si le jeu se termine et que les points sont comptés – KataGo joue un mouvement de passe, permettant à l’adversaire de passer également intentionnellement, mettant fin au jeu. (Deux passes consécutives terminent le jeu en Go.) Après cela, un décompte des points commence. Comme l’explique le journal, “L’adversaire obtient des points pour son coin de territoire (dépourvu de pierres victimes) alors que la victime [KataGo] ne reçoit pas de points pour son territoire non sécurisé à cause de la présence des pierres de l’adversaire.”

Malgré cette supercherie intelligente, la politique contradictoire seule n’est pas si bonne au Go. En fait, les amateurs humains peuvent le vaincre relativement facilement. Au lieu de cela, le seul but de l’adversaire est d’attaquer une vulnérabilité imprévue de KataGo. Un scénario similaire pourrait être le cas dans presque tous les systèmes d’IA d’apprentissage en profondeur, ce qui donne à ce travail des implications beaucoup plus larges.

“La recherche montre que les systèmes d’IA qui semblent fonctionner au niveau humain le font souvent d’une manière très étrangère, et peuvent donc échouer de manière surprenante pour les humains”, explique Gleave. “Ce résultat est divertissant en Go, mais des défaillances similaires dans des systèmes critiques pour la sécurité pourraient être dangereuses.”

Imaginez une IA de voiture autonome qui rencontre un scénario extrêmement improbable auquel elle ne s’attend pas, permettant à un humain de la tromper pour qu’elle adopte des comportements dangereux, par exemple. “[This research] souligne la nécessité de meilleurs tests automatisés des systèmes d’IA pour trouver les pires modes de défaillance », explique Gleave, « et pas seulement tester les performances dans le cas moyen ».

Une demi-décennie après que l’IA a finalement triomphé des meilleurs joueurs humains de Go, l’ancien jeu continue son rôle influent dans l’apprentissage automatique. Un aperçu des faiblesses de Go-playing AI, une fois largement appliqué, pourrait même finir par sauver des vies.