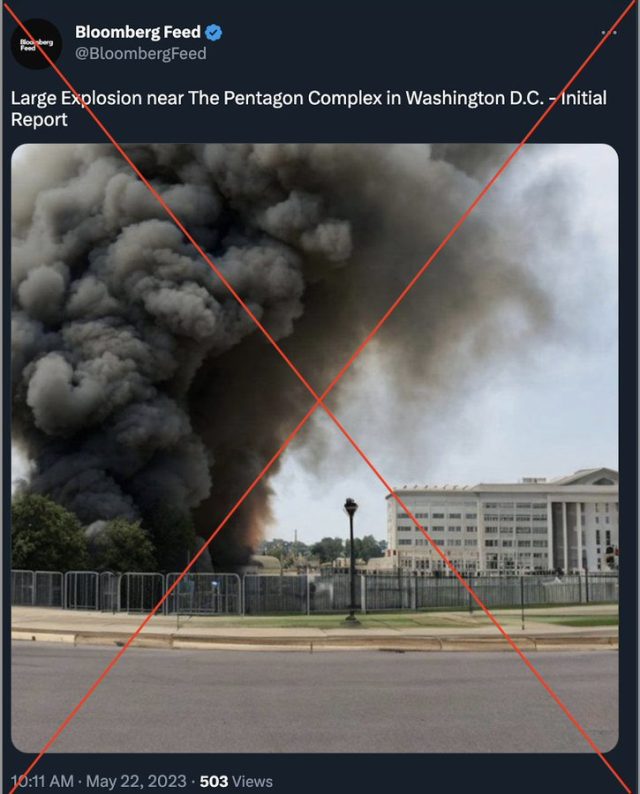

Agrandir / Une fausse image générée par l’IA d’une “explosion” près du Pentagone qui est devenue virale sur Twitter.

Lundi, une image générée par l’IA sur Twitter suggérant une grande explosion au Pentagone a conduit à une brève confusion, qui comprenait une petite baisse signalée du marché boursier. Il provenait d’un compte Twitter vérifié nommé “Bloomberg Feed”, non affilié à la célèbre société de médias Bloomberg, et a été rapidement révélé comme un canular. Cependant, avant qu’il ne soit démystifié, de grands comptes tels que Russia Today avaient déjà diffusé la désinformation, a rapporté le Washington Post.

La fausse image représentait un grand panache de fumée noire le long d’un bâtiment rappelant vaguement le Pentagone avec le tweet “Grande explosion près du complexe du Pentagone à Washington DC – Rapport initial”. Après une inspection plus approfondie, les autorités locales ont confirmé que l’image n’était pas une représentation exacte du Pentagone. De plus, avec des barres de clôture floues et des colonnes de construction, cela ressemble à une image générée par l’IA assez bâclée créée par un modèle comme Stable Diffusion.

Avant que Twitter ne suspende le faux compte Bloomberg, il avait tweeté 224 000 fois et atteint moins de 1 000 abonnés, selon le Post, mais on ne sait pas qui l’a dirigé ou les motifs derrière le partage de la fausse image. En plus de Bloomberg Feed, d’autres comptes qui ont partagé le faux rapport incluent “Walter Bloomberg” et “Breaking Market News”, tous deux non affiliés à la véritable organisation Bloomberg.

Cet incident souligne les menaces potentielles que les images générées par l’IA peuvent présenter dans le domaine des médias sociaux partagés à la hâte et d’un système de vérification payant sur Twitter. En mars, de fausses images de l’arrestation de Donald Trump créées avec Midjourney ont touché un large public. Bien qu’elles soient clairement marquées comme fausses, elles ont suscité des craintes de les confondre avec de vraies photos en raison de leur réalisme. Ce même mois, des images générées par l’IA du pape François en blouse blanche ont trompé de nombreuses personnes qui les ont vues sur les réseaux sociaux.

Publicité

Agrandir / Une capture d’écran du tweet “Bloomberg Feed” sur l’explosion signalée près du Pentagone qui a ensuite été confirmée comme fausse.

Agrandir / Une capture d’écran du tweet “Bloomberg Feed” sur l’explosion signalée près du Pentagone qui a ensuite été confirmée comme fausse.

Le pape en manteaux gonflés est une chose, mais lorsque quelqu’un présente un sujet gouvernemental comme le siège du département américain de la Défense dans un faux tweet, les conséquences pourraient potentiellement être plus graves. Mis à part la confusion générale sur Twitter, le tweet trompeur a peut-être affecté le marché boursier. Le Washington Post indique que l’indice industriel Dow Jones a chuté de 85 points en quatre minutes après la diffusion du tweet, mais a rebondi rapidement.

Une grande partie de la confusion sur le faux tweet a peut-être été rendue possible par des changements sur Twitter sous son nouveau propriétaire, Elon Musk. Musk a licencié les équipes de modération de contenu peu de temps après sa prise de contrôle et a largement automatisé le processus de vérification des comptes, le faisant passer à un système où n’importe qui peut payer pour avoir une coche bleue. Les critiques soutiennent que la pratique rend la plate-forme plus sensible à la désinformation.

Alors que les autorités ont facilement identifié la photo de l’explosion comme un faux en raison d’inexactitudes, la présence de modèles de synthèse d’images comme Midjourney et Stable Diffusion signifie qu’il n’est plus nécessaire d’avoir des compétences artistiques pour créer des faux convaincants, abaissant les barrières à l’entrée et ouvrant la porte à potentiellement automatisé machines de désinformation. La facilité de créer des contrefaçons, associée à la nature virale d’une plate-forme comme Twitter, signifie que les fausses informations peuvent se propager plus rapidement qu’elles ne peuvent être vérifiées.

Mais dans ce cas, l’image n’avait pas besoin d’être de haute qualité pour avoir un impact. Sam Gregory, le directeur exécutif de l’organisation de défense des droits de l’homme Witness, a souligné au Washington Post que lorsque les gens veulent croire, ils baissent leur garde et ne vérifient pas la véracité de l’information avant de la partager. Il a décrit la fausse image du Pentagone comme un “faux superficiel” (par opposition à un “deepfake” plus convaincant).

“La façon dont les gens sont exposés à ces contrefaçons peu profondes, il n’est pas nécessaire que quelque chose ressemble exactement à quelque chose d’autre pour attirer l’attention”, a-t-il déclaré. “Les gens prendront et partageront facilement des choses qui ne semblent pas tout à fait correctes mais qui se sentent bien.”