Agrandir / Un groupe de haut-parleurs intelligents Amazon Echo, y compris les modèles Echo Studio, Echo et Echo Dot. (Photo de Neil Godwin/Future Publishing via Getty Images)

Magazine T3/Getty Images

Des chercheurs universitaires ont mis au point un nouvel exploit fonctionnel qui réquisitionne les haut-parleurs intelligents Amazon Echo et les oblige à déverrouiller les portes, à passer des appels téléphoniques et des achats non autorisés, et à contrôler les fours, les fours à micro-ondes et d’autres appareils intelligents.

L’attaque fonctionne en utilisant le haut-parleur de l’appareil pour émettre des commandes vocales. Tant que le discours contient le mot de réveil de l’appareil (généralement “Alexa” ou “Echo”) suivi d’une commande autorisée, l’Echo l’exécutera, ont découvert des chercheurs de l’Université Royal Holloway de Londres et de l’Université italienne de Catane. Même lorsque les appareils nécessitent une confirmation verbale avant d’exécuter des commandes sensibles, il est trivial de contourner la mesure en ajoutant le mot « oui » environ six secondes après l’émission de la commande. Les attaquants peuvent également exploiter ce que les chercheurs appellent le “FVV”, ou vulnérabilité vocale complète, qui permet à Echos d’effectuer des commandes auto-émises sans réduire temporairement le volume de l’appareil.

Alexa, va te pirater

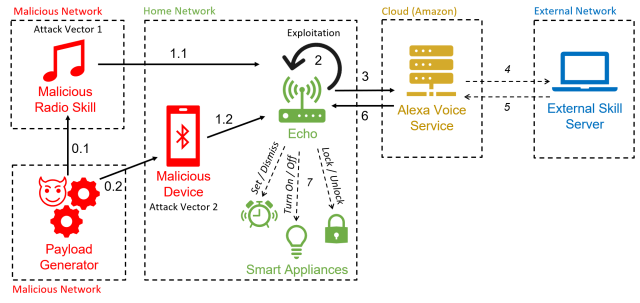

Parce que le piratage utilise la fonctionnalité Alexa pour forcer les appareils à effectuer des commandes auto-émises, les chercheurs l’ont surnommé “AvA”, abréviation d’Alexa contre Alexa. Il ne nécessite que quelques secondes de proximité avec un appareil vulnérable lorsqu’il est allumé afin qu’un attaquant puisse prononcer une commande vocale lui demandant de se coupler avec l’appareil compatible Bluetooth d’un attaquant. Tant que l’appareil reste à portée radio de l’Echo, l’attaquant pourra émettre des commandes.

L’attaque “est la première à exploiter la vulnérabilité des commandes arbitraires auto-émises sur les appareils Echo, permettant à un attaquant de les contrôler pendant une période prolongée”, ont écrit les chercheurs dans un article publié il y a deux semaines. “Avec ce travail, nous supprimons la nécessité d’avoir un haut-parleur externe près de l’appareil cible, augmentant ainsi la probabilité globale de l’attaque.”

Publicité

Une variante de l’attaque utilise une station de radio malveillante pour générer les commandes auto-émises. Cette attaque n’est plus possible de la manière indiquée dans l’article suite aux correctifs de sécurité publiés par Echo-maker Amazon en réponse à la recherche. Les chercheurs ont confirmé que les attaques fonctionnent contre les appareils Echo Dot de 3e et 4e génération.

Esposito et al.

AvA commence lorsqu’un appareil Echo vulnérable se connecte par Bluetooth à l’appareil de l’attaquant (et pour les Echos non patchés, lorsqu’ils diffusent la station de radio malveillante). À partir de là, l’attaquant peut utiliser une application de synthèse vocale ou d’autres moyens pour diffuser des commandes vocales. Voici une vidéo d’AvA en action. Toutes les variantes de l’attaque restent viables, à l’exception de ce qui est affiché entre 1:40 et 2:14 :

Alexa contre Alexa – Démo.

Les chercheurs ont découvert qu’ils pouvaient utiliser AvA pour forcer les appareils à exécuter une multitude de commandes, dont beaucoup avaient de graves conséquences sur la confidentialité ou la sécurité. Les actions malveillantes possibles incluent :

- Contrôler d’autres appareils intelligents, comme éteindre les lumières, allumer un four à micro-ondes intelligent, régler le chauffage à une température dangereuse ou déverrouiller les serrures de porte intelligentes. Comme indiqué précédemment, lorsque les échos nécessitent une confirmation, l’adversaire n’a qu’à ajouter un “oui” à la commande environ six secondes après la demande.

- Appelez n’importe quel numéro de téléphone, y compris celui contrôlé par l’attaquant, afin qu’il soit possible d’écouter les sons à proximité. Alors que les Echos utilisent une lumière pour indiquer qu’ils passent un appel, les appareils ne sont pas toujours visibles pour les utilisateurs, et les utilisateurs moins expérimentés peuvent ne pas savoir ce que signifie la lumière.

- Faire des achats non autorisés en utilisant le compte Amazon de la victime. Bien qu’Amazon enverra un e-mail informant la victime de l’achat, l’e-mail peut être manqué ou l’utilisateur peut perdre confiance en Amazon. Alternativement, les attaquants peuvent également supprimer des éléments déjà présents dans le panier du compte.

- Altération du calendrier précédemment lié d’un utilisateur pour ajouter, déplacer, supprimer ou modifier des événements.

- Imitez des compétences ou lancez n’importe quelle compétence au choix de l’attaquant. Ceci, à son tour, pourrait permettre aux attaquants d’obtenir des mots de passe et des données personnelles.

- Récupérer tous les énoncés prononcés par la victime. En utilisant ce que les chercheurs appellent une “attaque masquée”, un adversaire peut intercepter des commandes et les stocker dans une base de données. Cela pourrait permettre à l’adversaire d’extraire des données privées, de recueillir des informations sur les compétences utilisées et de déduire les habitudes des utilisateurs.

Publicité

Les chercheurs ont écrit :

Avec ces tests, nous avons démontré qu’AvA peut être utilisé pour donner des commandes arbitraires de n’importe quel type et longueur, avec des résultats optimaux. En particulier, un attaquant peut contrôler des lumières intelligentes avec un taux de réussite de 93 %, acheter avec succès des articles indésirables sur Amazon 100 % de les temps, et falsifier [with] un calendrier lié avec 88% de taux de réussite. Les commandes complexes qui doivent être reconnues correctement dans leur intégralité pour réussir, comme l’appel d’un numéro de téléphone, ont un taux de réussite quasi optimal, en l’occurrence 73 %. De plus, les résultats présentés dans le tableau 7 démontrent que l’attaquant peut mettre en place avec succès une attaque de masquage vocal via notre compétence Mask Attack sans être détecté, et tous les énoncés émis peuvent être récupérés et stockés dans la base de données de l’attaquant, à savoir 41 dans notre cas.