Agrandir / Une photo de presse du GPU Nvidia H100 Tensor Core.

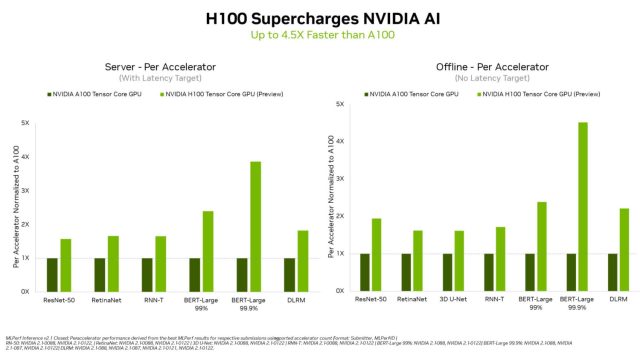

Nvidia a annoncé hier que son prochain GPU H100 “Hopper” Tensor Core a établi de nouveaux records de performances lors de ses débuts dans les benchmarks MLPerf standard de l’industrie, offrant des résultats jusqu’à 4,5 fois plus rapides que l’A100, qui est actuellement la puce AI de production la plus rapide de Nvidia.

Les benchmarks MPerf (appelés techniquement “MLPerfTM Inference 2.1”) mesurent les charges de travail “d’inférence”, qui démontrent à quel point une puce peut appliquer un modèle d’apprentissage automatique précédemment formé à de nouvelles données. Un groupe d’entreprises du secteur connu sous le nom de MLCommons a développé les benchmarks MLPerf en 2018 pour fournir une métrique standardisée permettant de transmettre les performances de l’apprentissage automatique aux clients potentiels.

Agrandir / Les résultats de référence H100 de Nvidia par rapport à l’A100, sous forme de graphique à barres sophistiqué.

Agrandir / Les résultats de référence H100 de Nvidia par rapport à l’A100, sous forme de graphique à barres sophistiqué.

Nvidia

En particulier, le H100 s’est bien comporté dans le benchmark BERT-Large, qui mesure les performances de traitement du langage naturel à l’aide du modèle BERT développé par Google. Nvidia attribue ce résultat particulier au Transformer Engine de l’architecture Hopper, qui accélère spécifiquement la formation des modèles de transformateurs. Cela signifie que le H100 pourrait accélérer les futurs modèles de langage naturel similaires au GPT-3 d’OpenAI, qui peut composer des œuvres écrites dans de nombreux styles différents et tenir des discussions conversationnelles.

Publicité

Nvidia positionne le H100 comme une puce GPU de centre de données haut de gamme conçue pour les applications d’intelligence artificielle et de superordinateur telles que la reconnaissance d’images, les grands modèles de langage, la synthèse d’images, etc. Les analystes s’attendent à ce qu’il remplace l’A100 en tant que GPU phare du centre de données de Nvidia, mais il est toujours en développement. Les restrictions du gouvernement américain imposées la semaine dernière sur les exportations de puces vers la Chine ont fait craindre que Nvidia ne soit pas en mesure de livrer le H100 d’ici la fin de 2022 puisqu’une partie de son développement s’y déroule.

Nvidia a précisé dans un deuxième dossier auprès de la Securities and Exchange Commission la semaine dernière que le gouvernement américain autorisera la poursuite du développement du H100 en Chine, de sorte que le projet semble sur la bonne voie pour le moment. Selon Nvidia, le H100 sera disponible “plus tard cette année”. Si le succès de la puce A100 de la génération précédente est une indication, le H100 pourrait alimenter une grande variété d’applications d’IA révolutionnaires dans les années à venir.