Agrandir / Une image générée par l’IA d’un robot lisant un livre.

Benj Edwards / Diffusion stable

Jeudi, la société d’IA Anthropic a annoncé qu’elle avait donné à son modèle de langage Claude AI de type ChatGPT la capacité d’analyser la valeur d’un livre entier en moins d’une minute. Cette nouvelle capacité provient de l’extension de la fenêtre contextuelle de Claude à 100 000 jetons, soit environ 75 000 mots.

Comme le GPT-4 d’OpenAI, Claude est un grand modèle de langage (LLM) qui fonctionne en prédisant le jeton suivant dans une séquence lorsqu’il reçoit une certaine entrée. Les jetons sont des fragments de mots utilisés pour simplifier le traitement des données de l’IA, et une “fenêtre contextuelle” est similaire à la mémoire à court terme – la quantité de données d’entrée fournies par l’homme qu’un LLM peut traiter à la fois.

Une fenêtre contextuelle plus grande signifie qu’un LLM peut considérer des travaux plus volumineux comme des livres ou participer à de très longues conversations interactives qui s’étendent sur “des heures, voire des jours”, selon Anthropic :

La personne moyenne peut lire 100 000 jetons de texte en environ 5 heures et plus, puis elle peut avoir besoin de beaucoup plus de temps pour digérer, mémoriser et analyser ces informations. Claude peut maintenant le faire en moins d’une minute. Par exemple, nous avons chargé l’intégralité du texte de Gatsby le magnifique dans Claude-Instant (72 000 jetons) et modifié une ligne pour dire que M. Carraway était « un ingénieur logiciel qui travaille sur les outils d’apprentissage automatique chez Anthropic ». Lorsque nous avons demandé au modèle de repérer ce qui était différent, il a répondu avec la bonne réponse en 22 secondes.

Bien que cela puisse ne pas sembler impressionnant de repérer les changements dans un texte (Microsoft Word peut le faire, mais seulement s’il a deux documents à comparer), considérez qu’après avoir fourni à Claude le texte de The Great Gatsby, le modèle d’IA peut alors répondre de manière interactive questions à ce sujet ou analyser sa signification. 100 000 jetons est une grande mise à niveau pour les LLM. En comparaison, le GPT-4 LLM d’OpenAI offre des longueurs de fenêtre de contexte de 4 096 jetons (environ 3 000 mots) lorsqu’il est utilisé dans le cadre de ChatGPT et 8 192 ou 32 768 jetons via l’API GPT-4 (qui n’est actuellement disponible que via la liste d’attente).

Publicité

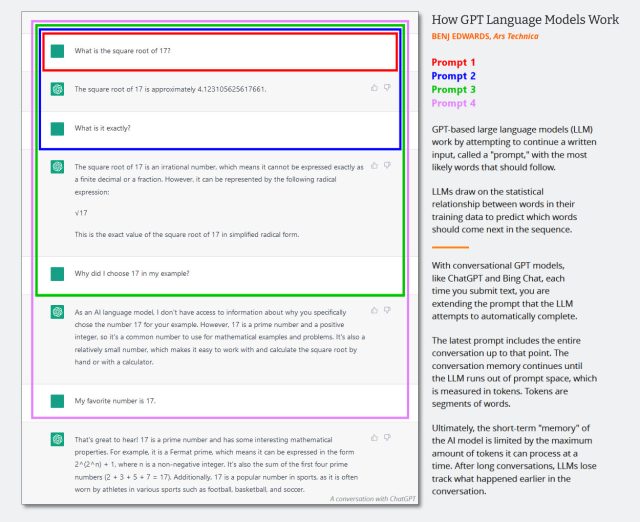

Pour comprendre comment une fenêtre contextuelle plus grande mène à une conversation plus longue avec un chatbot comme ChatGPT ou Claude, nous avons fait un diagramme pour un article précédent qui montre comment la taille de l’invite (qui se tient dans la fenêtre contextuelle) s’agrandit pour contenir l’ensemble texte de la conversation. Cela signifie qu’une conversation peut durer plus longtemps avant que le chatbot ne perde sa “mémoire” de la conversation.

Agrandir / Diagramme illustrant le fonctionnement de l’invite du modèle de langage conversationnel.

Agrandir / Diagramme illustrant le fonctionnement de l’invite du modèle de langage conversationnel.

Benj Edwards / Ars Technica

Selon Anthropic, les capacités améliorées de Claude s’étendent au-delà des livres de traitement. La fenêtre contextuelle élargie pourrait potentiellement aider les entreprises à extraire des informations importantes de plusieurs documents grâce à une interaction conversationnelle. La société suggère que cette approche peut surpasser les méthodes basées sur la recherche vectorielle lorsqu’il s’agit de requêtes complexes.

Une démonstration de l’utilisation de Claude en tant qu’analyste d’affaires, fournie par Anthropic.

Bien qu’il ne soit pas un nom aussi important dans l’IA que Microsoft et Google, Anthropic est devenu un rival notable d’OpenAI en termes d’offres compétitives dans les LLM et l’accès aux API. L’ancien vice-président de la recherche d’OpenAI, Dario Amodei, et sa sœur Daniela ont fondé Anthropic en 2021 après un désaccord sur la direction commerciale d’OpenAI. Notamment, Anthropic a reçu un investissement de 300 millions de dollars de Google fin 2022, Google acquérant une participation de 10 % dans l’entreprise.

Anthropic indique que 100 000 fenêtres contextuelles sont désormais disponibles pour les utilisateurs de l’API Claude, qui est actuellement limitée par une liste d’attente.